云计算不能忽视带宽问题云和虚拟化

简单的讲,如果你打算让企业的架构转向云计算,那么肯定会多多少少需要改变企业的网络带宽。目前大部分企业所选择的云计算项目都是最简单的带有数据保护机制的云存储解决方案。这就引发了一个问题,即企业现有的带宽能否支持云存储所需的庞大的数据流呢?

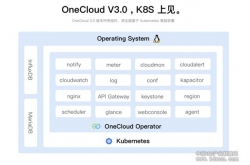

目前带有数据保护功能的云存储解决方案设备已经有不少了。比如Commvault的Simpana云存储集成方案。这套方案可以让管理员将需要保护的数据传输给所选定的一系列云存储供应商。下图显示了这个解决方案的新功能:

别误解我的意思,我真的很喜欢这个概念。问题是,我们应该为在本地和云存储供应商之间建立连接花费多少?虽然数据都被备份和加密了,但是现有的连接真的可以让我们将所需的数据及时传输出去给云服务商么?

我博客圈里的一个朋友Ethereal Mind 的Greg Ferro最近在Twitter中发表的文章验证了我的一个怀疑。 Greg 在他的博客中最后总结说,他所接触的那个云解决方案,比客户之前在自己的公司做的存储方案成本高了一倍。虽然每个厂商的云解决方案都不尽相同,我还是会想到带宽的问题。对于现在的网络状况,大部分企业的出口带宽有50兆或100兆就已经绰绰有余了。但是如果一旦加入了云存储的数据量,那么一切都将改变。

更进一步,初始负荷怎么解决?并不是所有企业的数据在云存储建好后都是从零开始积累,而是一开始就有海量的数据需要存储。综合各种因素,一般企业需要保存的初始数据是以TB计算的。

考虑到各种因素,是否采用云存储就需要三思而行了。让所有磁带设备都退休当然是好事。但是这取决于企业打算如何处理自身的静态数据,云存储是否能满足企业对数据的处理要求。毕竟,如果企业目前是将磁带存储在外部的数据仓库,并不能亲自到达现场处理磁带设备,那么云存储厂商同样也不能做到这一点。在以往有关云计算的文章中,数据失控的情况也是TechRepublic 社区一再讨论的问题。